Le Laboratoire d’Informatique, Systèmes, Traitement de l’Information et de la Connaissance développe une forte activité de recherche autour de l’analyse d’images et de l’intelligence artificielle, pour des projets académiques comme industriels. Afin de faire face aux besoins importants en analyse d’images et aux volumes massifs de données à traiter, une expertise avec le mésocentre MUST s’est construite, notamment dans le calcul sur GPU.

Parmi les nombreux travaux poursuivis, citons :

-

La description de données spatiotemporelles pour l’indexation de vidéos

-

L’analyse d’images hyperspectrales : deep-learning et optimisation de la plateforme de calcul MUST

-

L’informatique Affective par vision

-

La surveillance structurelle et observation de la Terre par télédétection

-

Le transfert technologique vers les entreprises

Ces travaux ont amené la plateforme à associer aux moyens de calcul classiques (CPU), des serveurs de calcul spécifiques équipées de processeurs graphiques (GPU) dédiés aux problématiques d’intelligence artificielle actuelles.

Description de données spatiotemporelles pour l’indexation de vidéos

Des travaux sur l’indexation d’image et séquences vidéo ont été développés autour du concours international TRECVid. Associé au consortium IRIM rassemblant jusque 14 laboratoires français, le LISTIC a développé des méthodes de description de contenus de sorte à ce que les moteurs de recherche associent une requête vidéo à des contenus similaires dans de grandes bases de données. Le consortium IRIM s’est classé au quatrième rang mondial à quatre reprises sur la période 2012-2017.

Grâce au traitement des vidéos réalisé en parallèle par les centaines de processeurs (CPU) de MUST les temps de calculs sont très fortement réduits.

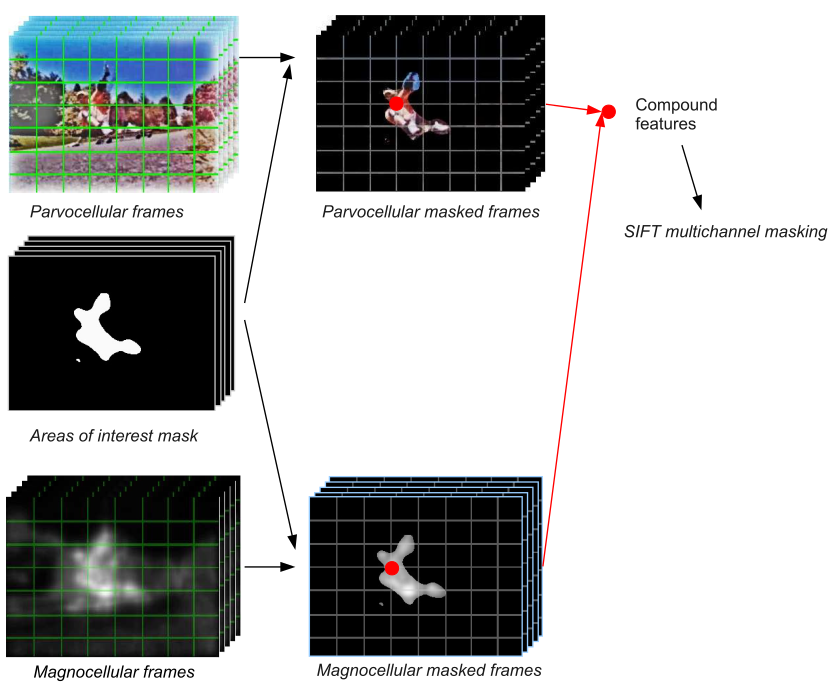

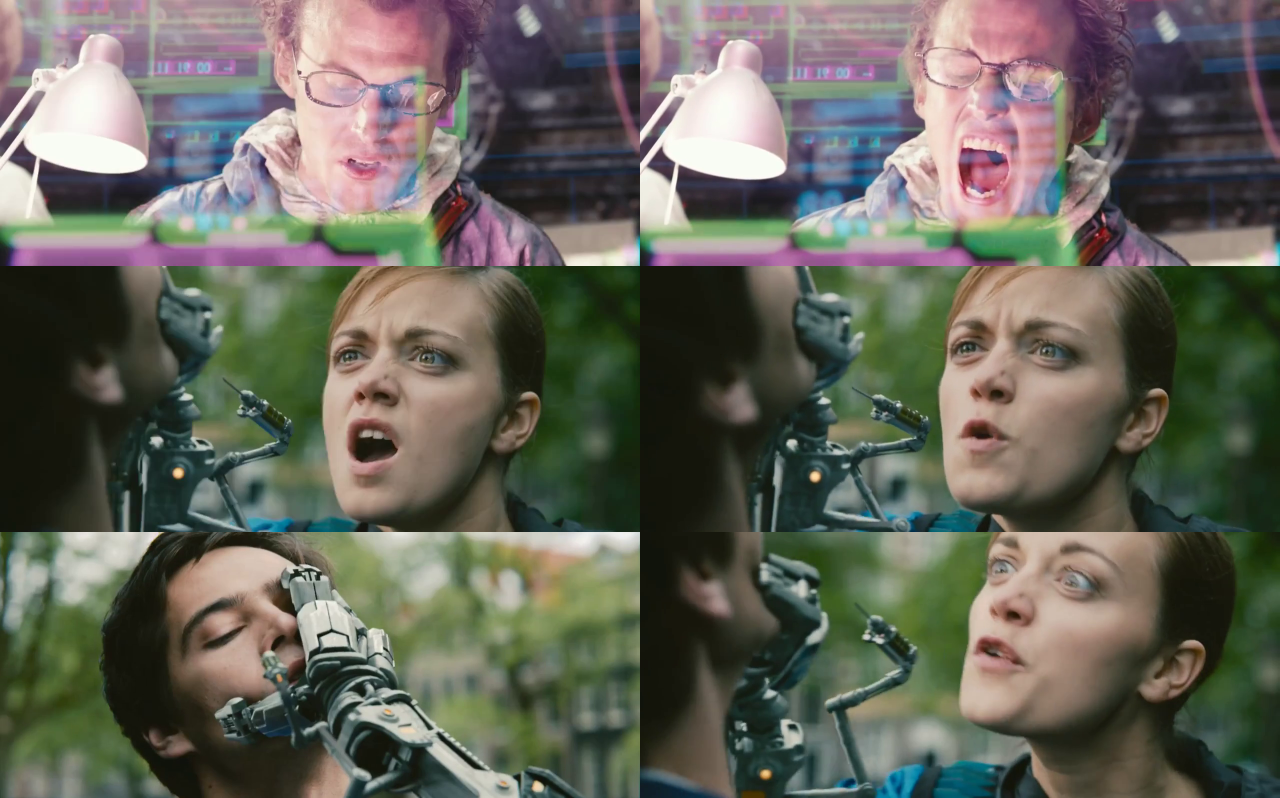

La figure ci-dessous illustre des données spatiotemporelles extraites des vidéos par le LISTIC. Un modèle bio inspiré de rétine mis à disposition dans la bibliothèque OpenCV permet de sélectionner les zones d’intérêt dans une vidéo et la décompose en une information temporelle (le mouvement) et structurelle (la texture, le détail). Ces données sont ensuite fusionnées pour créer un descripteur pertinent permettant d’indexer les contenus.

Analyse d’images hyperspectrales : deep-learning et optimisation de la plateforme de calcul MUST

Le LISTIC développe de nombreux travaux académiques autour de l’observation de la terre. Dans ce cadre, le LISTIC a mené des travaux sur l’analyse d’images hyperspectrales pour la caractérisation de types de sols grâce à des approches innovantes basées sur des réseaux de neurones profonds ou deep-learning.

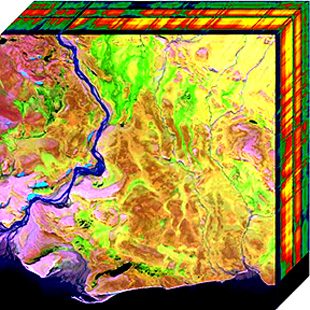

Une image hyperspectrale (source : https://en.wikipedia.org/wiki/Hyperspectral_imaging)

Comme suggéré par l’image ci-dessus, les images hyperspectrales permettent de décrire chaque pixel selon plusieurs centaines de bandes spectrales. L’information est très dense mais la connaissance associée fort limitée. Optimiser les millions de paramètres de réseaux de neurones dans ce contexte est alors difficile.

Pour résoudre ce problème, le LISTIC a proposé l’utilisation de réseaux de neurones présentant une structure adaptée aux données. Très légers en nombre de paramètres, ces modèles sont associés à des stratégies d’optimisation ciblées permettant de réduire significativement le nombre d’étapes d’apprentissage. Ces propositions ont pu être validées grâce à des optimisations réalisées sur la plateforme MUST sur des serveurs de calcul spécifiques équipées de processeurs graphiques (GPU).

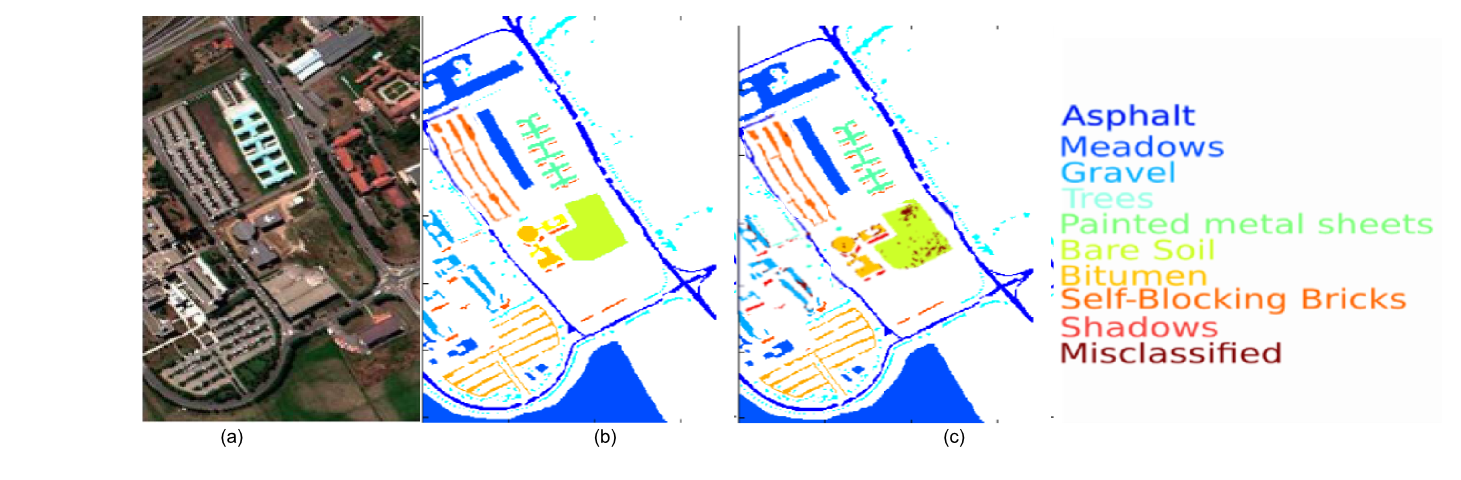

La figure ci-dessous donne un exemple de résultat. Partant d’une image hyperspectrale à 100 bandes par pixels représentée à gauche en pseudo couleurs. Le modèle proposé prédit une catégorie de sol pour chaque pixel comme illustré en couleur sur la figure de droite. Les performances sont comparées à une connaissance experte du terrain illustré sur la figure centrale. Le modèle obtient 97% de bonne prédiction sur des pixels non vus à l’entrainement en ne s’étant entrainé que sur 4% des données.

Contact : Alexandre Benoit

Informatique affective par vision

Une intelligence artificielle, peut-elle s’approcher des performances de l’homme en reconnaissance du caractère violent d’une scène ?

Une intelligence artificielle, peut-elle s’approcher des performances de l’homme en reconnaissance du caractère violent d’une scène ?

A travers le verrouillage d’applications spécifiques ou le filtrage de sites web et de données de navigation, les logiciels dits « de contrôle parental » sont des outils visant à interdire l’accès à des images ou à des vidéos indésirables. Toute image impacte en effet émotionnellement l’individu qui la regarde : selon son contenu, elle l’affecte, parfois à long terme. Ces logiciels peuvent être mis en en défaut : par la consultation de résultats inappropriés d’une recherche par mots-clés, l’accès aux réseaux sociaux ou le visionnage de contenus multimédia à la description floue. Pour contourner cet écueil, le recours à « l’informatique affective », c’est-à-dire à la capacité d’un système informatique à reconnaitre le caractère sensible ou émotionnelle d’une vidéo par analyse automatique de son contenu, indépendamment du descriptif annoncé par la source, est envisageable. Cette solution permettrait d’être informé à l’avance de son niveau de convenance et d’évaluer ainsi sereinement l’opportunité de visionner cette vidéo ou ces images. Dans le cadre du projet SAINS financé par l’USMB, en utilisant les ressources de calcul de MUST, dont MATLAB, le LISTIC a mené une étude en informatique affective visant à classer automatiquement des contenus vidéo (plus de 11 000 clips examinés), comme si le robot les visionnait à la place de son destinataire. La catégorisation des vidéos a été faite par la seule analyse statistique et sémantique des pixels de celle-ci.

Les résultats de l’étude ont montré qu’une intelligence artificielle est capable, par apprentissage profond, d’atteindre des taux élevés de reconnaissance du caractère violent d’une scène.

Surveillance structurelle et observation de la Terre par télédétection

PHOENIX est un projet ANR qui a été porté par le LISTIC. Mené à partir d’octobre 2015, il a été le fruit de quatre années de collaboration avec des experts universitaires français et brésiliens, ainsi qu’avec le laboratoire de recherche SONDRA.

Son objectif : étudier la résilience au changement de structures à grande échelle telles que les glaciers alpins et la forêt amazonienne. Pour ce faire, il a été question d’analyser les états passés et actuels de ces structures afin de caractériser les conséquences des transformations auxquelles elles sont soumises, ceci grâce à l’emploi de modèles mathématiques appliqués à de grandes quantités de données de télédétection.

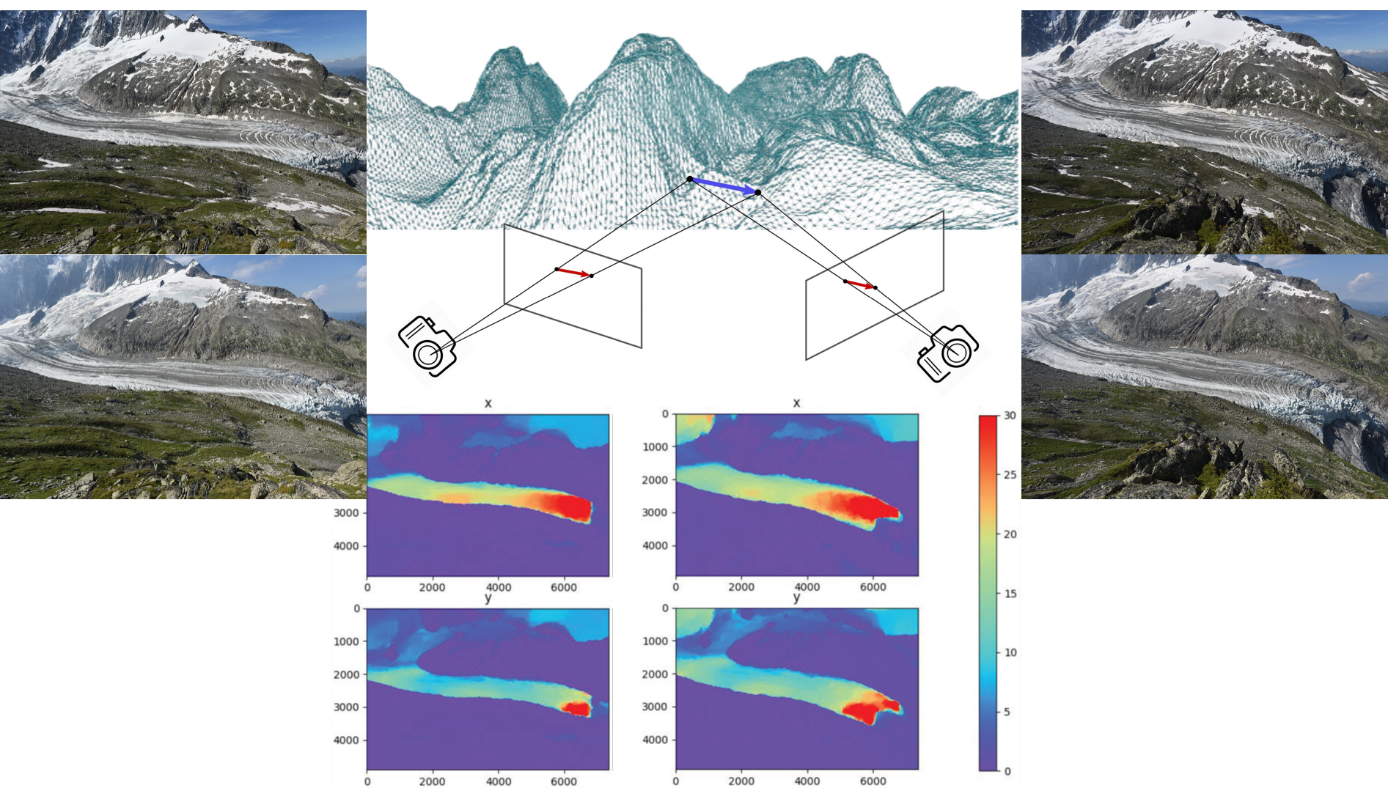

Dans le cadre de travaux de thèse, le projet PHOENIX a porté un intérêt particulier au calcul de champs de déplacement du glacier d’Argentière. La figure ci-dessous illustre le contexte de calcul de champs de vélocité pixélique obtenus sur ce glacier à partir de deux paires d’images associées respectivement aux caméras droite et gauche positionnées face au glacier.

Les zones en bleu foncé sur les 4 cartes de vélocité sont supposées statiques. Les zones en rouge sont les zones les plus dynamiques.

Les zones en bleu foncé sur les 4 cartes de vélocité sont supposées statiques. Les zones en rouge sont les zones les plus dynamiques.

Dans la continuité de cette étude et afin d’analyser de très longues séries temporelles, le LISTIC étudie l’emploi d’une nouvelle méthode automatique de calcul de champs de déplacement : ses données de sortie seront utilisées pour proposer des modèles génératifs et prédictifs des dits champs de déplacement. Alors qu’il s’agit de modèles complexes d’apprentissage profond, nécessitant de nombreuses heures de calcul à haute performance, le recours aux ressources de calcul de MUST s’est imposé.

Contact : Abdourrahmane M. ATTO

Transfert technologique et accompagnement d’entreprises

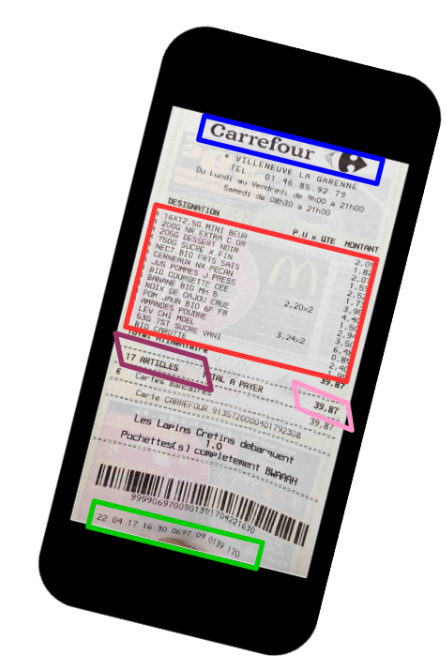

Le LISTIC aide au développement et au transfert de briques technologiques vers le monde industriel. Le laboratoire a ainsi accompagné les entreprises AboutGoods et SmarterPlan sur des problématiques de détection d’objets dans des images via des approches basées sur des réseaux de neurones profonds.

- pour la société AboutGoods, il s’agit de détecter automatiquement des tickets de caisse grâce à une simple photographie prise par smartphone. Cette solution ouvre à l’analyse automatique de la liste d’achats permettant de créer des services de suivi de consommation.

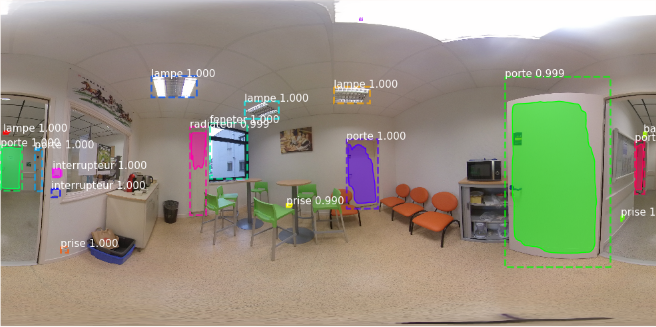

- pour la startup SmarterPlan, il est question de détecter de multiples objets dans les bâtiments depuis des prises de vue 360°. L’idée est de pouvoir créer de nouveaux services gravitant autour des processus de gestion des bâtiments et de leurs données (BIM). Dans le cadre de ces études, des serveurs de calculs spécifiques équipées de processeurs graphiques (GPU) dédiés à la problématique d’intelligence artificielle ont été achetés et installés sur la plateforme MUST. Ceux-ci permettent une accélération significative des temps de calcul optimisant ainsi les approches deep-learning.